Docker Compose

Docker Compose

En el artículo Creación de imágenes para Docker vimos como crear imágenes para Docker, pero si necesitáramos configurar una aplicación compleja que ejecuta múltiples...

Creación de imágenes para Docker

Creación de imágenes para Docker

La creación de imágenes para Docker puede tener diversas razones, ya sea porque no puede encontrar un componente o un...

Resumen de comandos de Docker

Resumen de comandos de Docker:

Puedes descargar un resumen de comandos de Docker en imágen para imprimir, está en inglés:

Descarga imagen parte 1

Descarga imagen parte...

Práctica con el comando run de Docker

Práctica con el comando run de Docker

En esta demostración, veremos algunas de las opciones avanzadas del comando “run” que vimos en el artículo Opciones...

Opciones del comando run de Docker

Opciones del comando run de Docker run:

Aunque en el artículo de Primeros pasos con Docker vimos el comando "run", en este artículo vamos a...

Práctica básica con Docker

Práctica básica con Docker:

Carga de imágenes

Vamos a realizar una práctica básica con Docker, en concreto lo que hemos visto en el artículo de Primeros...

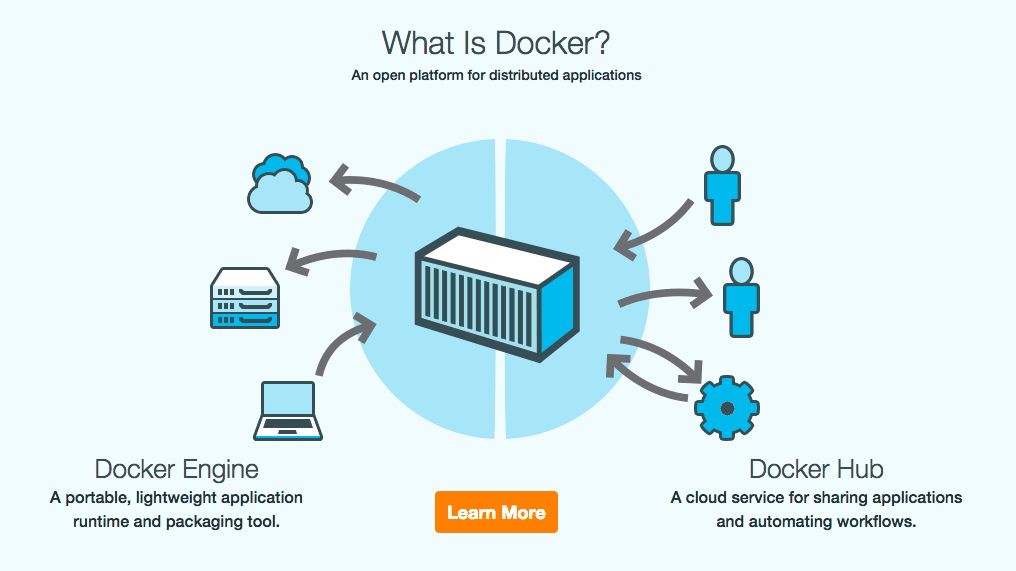

Primeros pasos con Docker

Primeros pasos con Docker: Instalación:

Para dar los primeros pasos en Docker hay que que tener en cuenta que existen dos ediciones. Community Edition es la...