Construyendo árboles de decisión

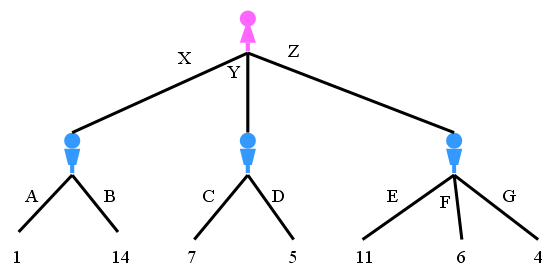

Vamos a ver como se están construyendo los árboles de decisión: se crean utilizando el particionamiento recursivo para clasificar los datos. El algoritmo elige la característica más predictiva en la que se deben dividir los datos. Lo que es importante en la elaboración de un árbol de decisiones es determinar qué atributo es el mejor, o más predictivo, para dividir los datos en función de la característica. La «predictibilidad» se basa en la disminución de la «impureza» de los nodos. Un nodo en el árbol se considera «puro» si, en el 100% de los casos, los nodos caen en una categoría específica del campo objetivo. De hecho, el método utiliza el particionamiento recursivo para dividir los registros en segmentos minimizando la «impureza» en cada paso. La «Impureza» de los nodos se calcula mediante la «Entropía» de los datos en el nodo.

VER EJEMPLO EN PYTHON

¿qué es «Entropía»?

La entropía es la cantidad de desorden de la información, o la cantidad de aleatoriedad en los datos. La entropía en un nodo depende de la cantidad de datos aleatorios que se encuentran en ese nodo y se debe calcular para cada nodo. En los árboles de decisión, buscamos a los árboles que tengan la entropía más pequeña en sus nodos. La entropía se utiliza para calcular la homogeneidad de las muestras en ese nodo. Si las muestras son completamente homogéneas la entropía es cero y si las muestras son divididas equitativamente tiene una entropía de uno.

Es posible calcular la entropía de un nodo utilizando la tabla de frecuencias del atributo a través de la fórmula de Entropía: ![]()

![]()

![]()

![]()

Pero ¿qué atributo resulta en más nodos puros? ¿en qué árbol tenemos menos entropía después de la división en lugar de antes de la división? La respuesta es en el árbol con la mayor ganancia de información después de la división. Pero, ¿qué es la ganancia de información? La ganancia de información es la información que puede aumentar el nivel de certeza después de la división. Es la entropía de un árbol antes de la división menos la entropía ponderada después de la división por un atributo. Podemos pensar en la ganancia de la información y en la entropía como opuestos. Como la entropía, o la cantidad de aleatoriedad, disminuye, la ganancia de la información, o la cantidad de certeza, aumenta, y viceversa. Por lo tanto, la construcción de un árbol de decisión se trata de encontrar atributos que devuelvan la más alta ganancia de información.

Deberíamos repetir el proceso para cada rama,y probar cada uno de los otros atributos para alcanzar la mayor cantidaddes hojas puras.

Ir al artículo anterior de la serie: Introducción a los árboles de decisión

Ir al artículo siguiente de la serie:Introducción a la Regresión Logística